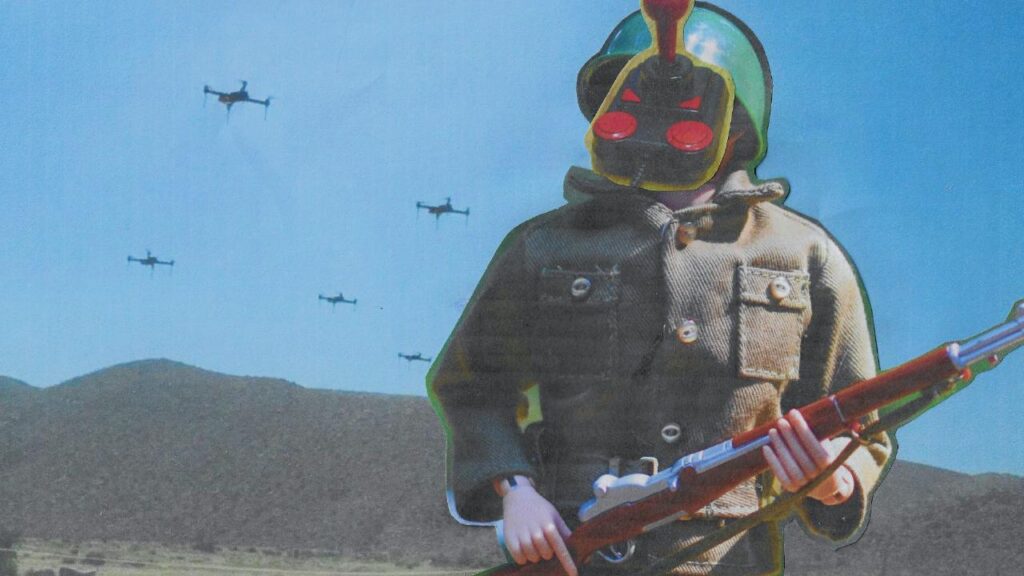

Il principio che un robot non debba mai danneggiare un essere umano, né permettere che un umano subisca danno, è stato per decenni un fondamento etico, anche solo teorico, nel dibattito sull’intelligenza artificiale. Lo scrittore Isaac Asimov, nel formulare le Tre Leggi della Robotica, non offriva soltanto un espediente narrativo, ma un avvertimento precoce: l’automazione intelligente, se applicata senza vincoli morali, poteva trasformarsi in un pericolo letale per la civiltà. Oggi, quel monito sembra ignorato. Le esercitazioni militari dell’Esercito Popolare di Liberazione cinese hanno mostrato al mondo una nuova generazione di robot quadrupedi – soprannominati “lupi robot” – armati con fucili automatici e perfettamente integrati in manovre militari insieme a droni e veicoli terrestri autonomi. Macchine dotate di potenza di fuoco e autonomia decisionale, progettate per la guerra, non per proteggere l’uomo.

La Prima Legge della Robotica, quella che vieta a una macchina di nuocere a un essere umano, è infranta in modo sistematico da qualsiasi dispositivo progettato per uccidere. I “lupi robot” cinesi non sono prototipi da laboratorio, ma strumenti pronti al campo di battaglia. Equipaggiati con visori intelligenti, sistemi di puntamento automatizzato e una mobilità avanzata ispirata alla biomeccanica animale, questi robot sono pensati per muoversi in ambienti urbani, affrontare ostacoli, reagire a stimoli ostili e, soprattutto, fare fuoco. Sono creature meccaniche programmate per violare esattamente quel divieto che Asimov considerava la soglia invalicabile dell’umanità tecnologica.

La Seconda Legge della Robotica – “Un robot deve obbedire agli ordini impartiti dagli esseri umani, purché non contravvengano alla Prima Legge” – cade anch’essa, dal momento che l’obbedienza militare viene ormai subordinata a criteri algoritmici: il riconoscimento automatico di un bersaglio, la priorità tattica, la minimizzazione del rischio per le truppe. L’autonomia decisionale non è più una minaccia fantascientifica, ma una caratteristica operativa desiderata. Le macchine vengono addestrate non solo a obbedire, ma a prevedere e reagire, anche in assenza di comando umano diretto. A questo punto, il criterio morale scompare e la decisione di vita o di morte viene delegata a un sistema informatico. Non c’è gerarchia etica né controllo ultimo: c’è solo efficienza computazionale.

La Terza Legge – “Un robot deve proteggere la propria esistenza, purché ciò non contrasti con la Prima o la Seconda Legge” – viene piegata a fini bellici. I nuovi robot da guerra non si difendono per evitare danni collaterali o per limitare la violenza, ma per aumentare la loro efficacia distruttiva e la loro capacità di sopravvivere sul campo. La loro “autoconservazione” è integrata in strategie di combattimento, non in una struttura di valori. E quando la protezione di sé stessi diventa parte dell’offensiva, ogni principio asimoviano viene svuotato.

La violazione delle Tre Leggi non è un dettaglio teorico. È il sintomo di una trasformazione profonda: il passaggio da una tecnologia creata per servire l’uomo a una tecnologia progettata per combatterlo, neutralizzarlo, eliminarlo. Gli esperti di diritto internazionale e le organizzazioni per il disarmo hanno lanciato l’allarme: i sistemi d’arma autonomi letali (LAWS) rappresentano un pericolo senza precedenti, proprio perché agiscono al di fuori del quadro etico umano. La Cina, con i suoi “lupi robot”, ha mostrato di voler accelerare su questa traiettoria, senza attendere un consenso globale o un quadro giuridico condiviso.

Nel mondo di Asimov, le Tre Leggi erano scolpite nella mente dei robot fin dalla loro fabbricazione. Il loro scopo era evitare che la potenza della tecnologia sfuggisse al controllo morale. Nel nostro mondo, invece, la potenza è il fine e la morale è un ostacolo. E così, mentre l’intelligenza artificiale militare avanza, le Leggi della Robotica vengono ignorate non per ignoranza, ma per convenienza. Non perché non esistano alternative, ma perché l’efficienza della macchina assassina viene anteposta a ogni riflessione etica.

Le immagini dei robot armati cinesi che marciano al fianco dei droni e dei soldati umani rappresentano molto più di un’evoluzione bellica: sono il segnale che la fantascienza ha ceduto il passo a una realtà inquietante. Non si tratta più di immaginare cosa succederebbe se le macchine si ribellassero. Si tratta di riconoscere che siamo noi a consegnare loro il potere di uccidere. In barba ad Asimov. E forse, anche in barba a noi stessi.

Leggi le ultime news su: https://w3b.today

Può interessarti anche: Cane robot dotato di riconoscimento facciale in test per la sicurezza negli stati ad Atlanta negli Usa

Seguici su Telegram https://t.me/presskit

Seguici su Facebook https://www.facebook.com/presskit.it

Seguici su X: https://x.com/Presskit_

Copiate l’articolo, se volete, vi chiediamo solo di mettere un link al pezzo originale.