“Un nuovo strumento consente agli artisti di aggiungere modifiche invisibili ai pixel nella loro arte prima di caricarla online in modo che, se inserita in un set di formazione AI, possa causare la rottura del modello risultante in modi caotici e imprevedibili”, spiega Melissa Heikkilä sul blog del Mit di Boston.

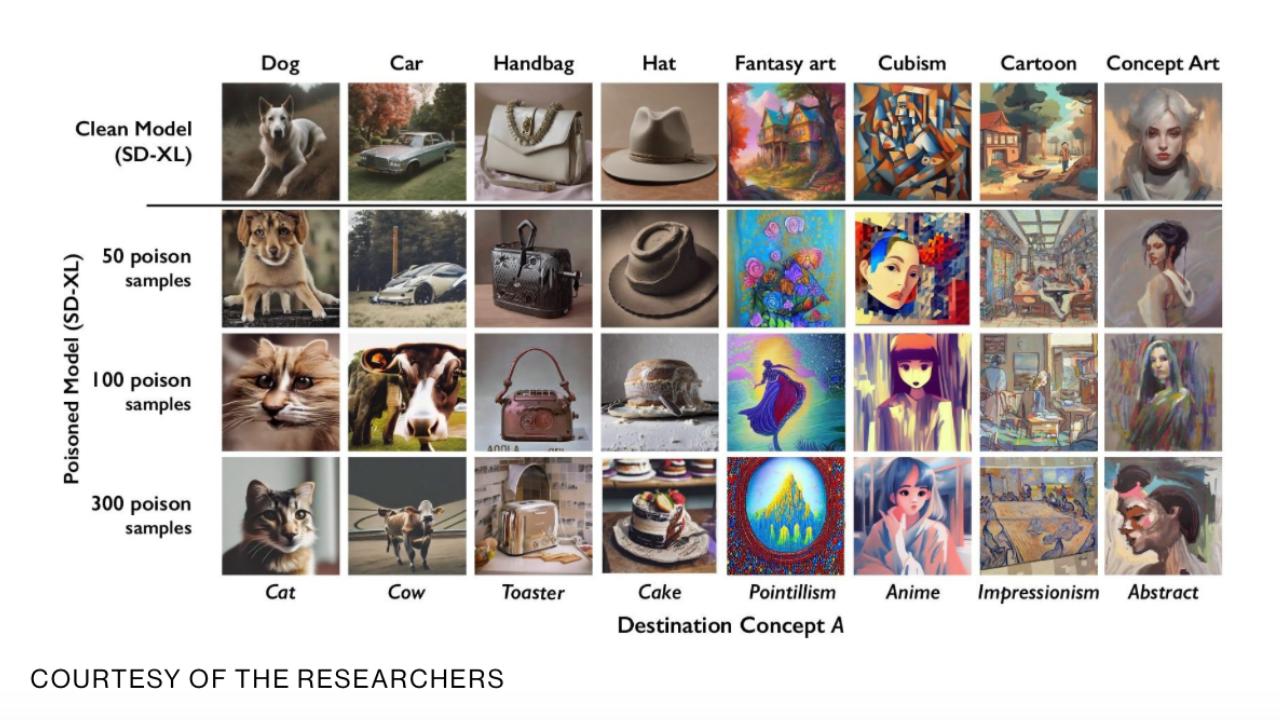

“Lo strumento, chiamato Nightshade, è inteso come un modo per combattere le aziende di intelligenza artificiale che utilizzano il lavoro degli artisti per addestrare i propri modelli senza il permesso del creatore. Usarlo per “avvelenare” questi dati di addestramento potrebbe danneggiare le future iterazioni dei modelli di intelligenza artificiale che generano immagini, come DALL-E, Midjourney e Stable Diffusion, rendendo inutili alcuni dei loro risultati: i cani diventano gatti, le auto diventano mucche e così via. via. La MIT Technology Review ha ottenuto un’anteprima esclusiva della ricerca, che è stata sottoposta per la revisione paritaria alla conferenza sulla sicurezza informatica Usenix.

Società di intelligenza artificiale come OpenAI, Meta, Google e Stability AI si trovano ad affrontare una serie di cause legali da parte di artisti che affermano che il loro materiale protetto da copyright e le loro informazioni personali sono stati sottratti senza consenso o compenso. Ben Zhao, professore all’Università di Chicago, che ha guidato il team che ha creato Nightshade, afferma che la speranza è che possa contribuire a spostare l’equilibrio di potere dalle società di intelligenza artificiale a favore degli artisti, creando un potente deterrente contro la mancanza di rispetto dei diritti d’autore e dei diritti intellettuali degli artisti. proprietà. Meta, Google, Stability AI e OpenAI non hanno risposto alla richiesta di commento del MIT Technology Review su come avrebbero potuto rispondere.

Il team di Zhao ha anche sviluppato Glaze, uno strumento che consente agli artisti di “mascherare” il proprio stile personale per evitare che venga cancellato dalle società di intelligenza artificiale. Funziona in modo simile a Nightshade: modificando i pixel delle immagini in modi sottili che sono invisibili all’occhio umano ma manipolano modelli di apprendimento automatico per interpretare l’immagine come qualcosa di diverso da ciò che mostra effettivamente.

Il team intende integrare Nightshade in Glaze e gli artisti possono scegliere se utilizzare o meno lo strumento di avvelenamento dei dati. Il team sta anche rendendo Nightshade open source, il che consentirebbe ad altri di armeggiare con esso e creare le proprie versioni. Più persone lo usano e ne creano le proprie versioni, più potente diventa lo strumento, dice Zhao. I set di dati per modelli di intelligenza artificiale di grandi dimensioni possono essere costituiti da miliardi di immagini, quindi più immagini avvelenate possono essere inserite nel modello, maggiore sarà il danno che la tecnica causerà.

I ricercatori hanno testato l’attacco sugli ultimi modelli di Stable Diffusion e su un modello di intelligenza artificiale addestrato da zero. Quando hanno dato a Stable Diffusion solo 50 immagini avvelenate di cani e poi gli hanno chiesto di creare immagini dei cani stessi, il risultato ha iniziato a sembrare strano: creature con troppi arti e facce da cartone animato. Con 300 campioni avvelenati, un utente malintenzionato può manipolare la diffusione stabile per generare immagini di cani che assomiglino a gatti.

Un attacco mirato

Nightshade sfrutta una vulnerabilità di sicurezza nei modelli di intelligenza artificiale generativa, derivante dal fatto che sono addestrati su grandi quantità di dati, in questo caso immagini recuperate da Internet. Nightshade confonde quelle immagini.

Gli artisti che desiderano caricare il proprio lavoro online ma non vogliono che le loro immagini vengano cancellate dalle società di intelligenza artificiale possono caricarle su Glaze e scegliere di mascherarle con uno stile artistico diverso dal loro. Possono quindi anche scegliere di utilizzare Nightshade. Una volta che gli sviluppatori di intelligenza artificiale raschiano Internet per ottenere più dati per modificare un modello di intelligenza artificiale esistente o crearne uno nuovo, questi campioni avvelenati si insinuano nel set di dati del modello e ne causano il malfunzionamento.

Campioni di dati avvelenati possono manipolare i modelli per apprendere, ad esempio, che le immagini dei cappelli sono torte e le immagini delle borse sono tostapane. I dati avvelenati sono molto difficili da rimuovere, poiché richiedono alle aziende tecnologiche di trovare ed eliminare scrupolosamente ogni campione corrotto.

I ricercatori hanno testato l’attacco sugli ultimi modelli di Stable Diffusion e su un modello di intelligenza artificiale addestrato da zero. Quando hanno dato a Stable Diffusion solo 50 immagini avvelenate di cani e poi gli hanno chiesto di creare immagini dei cani stessi, il risultato ha iniziato a sembrare strano: creature con troppi arti e facce da cartone animato. Con 300 campioni avvelenati, un utente malintenzionato può manipolare la diffusione stabile per generare immagini di cani che assomiglino a gatti.

I modelli di intelligenza artificiale generativa sono eccellenti nel creare connessioni tra le parole, il che aiuta la diffusione del veleno. Nightshade infetta non solo la parola “cane” ma tutti i concetti simili, come “cucciolo”, “husky” e “lupo”. L’attacco velenoso funziona anche su immagini correlate tangenzialmente. Ad esempio, se il modello prelevasse un’immagine avvelenata per il prompt “arte fantasy”, i prompt “drago” e “un castello nel Signore degli Anelli” verrebbero similmente manipolati in qualcos’altro.

Zhao ammette che esiste il rischio che le persone possano abusare della tecnologia di avvelenamento dei dati per usi dannosi. Tuttavia, afferma che gli aggressori avrebbero bisogno di migliaia di campioni avvelenati per infliggere danni reali a modelli più grandi e potenti, poiché sono addestrati su miliardi di campioni di dati.

“Non conosciamo ancora difese robuste contro questi attacchi. Non abbiamo ancora assistito ad attacchi avvelenanti contro i moderni modelli [di machine learning] in natura, ma potrebbe essere solo questione di tempo”, afferma Vitaly Shmatikov, professore alla Cornell University che studia la sicurezza dei modelli di intelligenza artificiale e non è stato coinvolto nel progetto. ricerca. “Il momento di lavorare sulle difese è adesso”, aggiunge Shmatikov.

Gautam Kamath, professore assistente presso l’Università di Waterloo che ricerca la privacy dei dati e la robustezza nei modelli di intelligenza artificiale e non è stato coinvolto nello studio, afferma che il lavoro è “fantastico”.

La ricerca mostra che le vulnerabilità “non scompaiono magicamente per questi nuovi modelli, ma anzi diventano solo più gravi”, afferma Kamath. “Ciò è particolarmente vero in quanto questi modelli diventano più potenti e le persone ripongono in loro maggiore fiducia, poiché la posta in gioco non fa che aumentare nel tempo”.

Un potente deterrente

Junfeng Yang, professore di informatica alla Columbia University, che ha studiato la sicurezza dei sistemi di deep learning e non è stato coinvolto nel lavoro, afferma che Nightshade potrebbe avere un grande impatto se indurrà le società di intelligenza artificiale a rispettare maggiormente i diritti degli artisti, ad esempio , essendo più disposti a pagare royalties.

Le aziende di intelligenza artificiale che hanno sviluppato modelli generativi da testo a immagine, come Stability AI e OpenAI, si sono offerte di consentire agli artisti di scegliere di non utilizzare le loro immagini per addestrare le versioni future dei modelli. Ma gli artisti dicono che questo non basta. Eva Toorenent, illustratrice e artista che ha utilizzato Glaze, afferma che le politiche di opt-out richiedono agli artisti di fare i salti mortali e di lasciare comunque alle aziende tecnologiche tutto il potere.

Toorenent spera che Nightshade possa cambiare lo status quo.

“Ciò farà riflettere due volte [le aziende di intelligenza artificiale], perché hanno la possibilità di distruggere il loro intero modello prendendo il nostro lavoro senza il nostro consenso”, afferma.

Autumn Beverly, un’altra artista, afferma che strumenti come Nightshade e Glaze le hanno dato la sicurezza necessaria per pubblicare nuovamente il suo lavoro online. L’aveva precedentemente rimossa da Internet dopo aver scoperto che era stata raschiata senza il suo consenso nel popolare database di immagini LAION.

“Sono davvero grata di avere uno strumento che può aiutare a restituire agli artisti il potere per il proprio lavoro”, afferma”.

Tradotto da: Fonte

Si può scaricare qui.

Le opinioni espresse in questo articolo sono dell’autore.

Leggi le ultime news su: https://w3b.today

Può interessarti anche: Immagini con abusi sessuali su minori usati per allenare l’intelligenza artificiale. Lo studio della Stanford University Cyber Policy Center

Seguici su Telegram https://t.me/presskit

Seguici su Facebook https://www.facebook.com/presskit.it

Copiate l’articolo, se volete, vi chiediamo solo di mettere un link al pezzo originale.