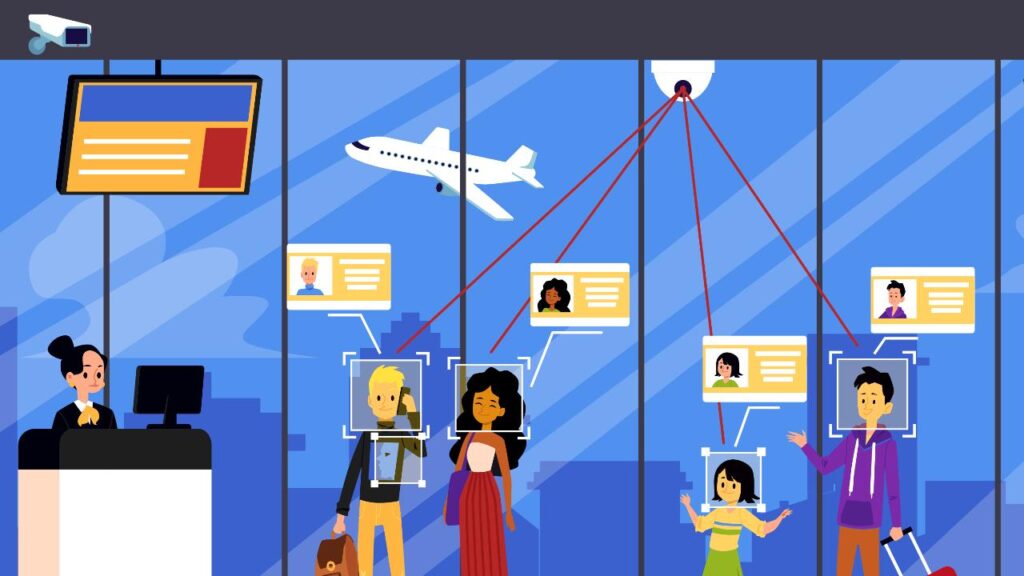

La prima grande rivoluzione furono le impronte digitali oggi si passa al riconoscimento facciale. Lo fanno per il nostro bene, o almeno così dicono. A Milano vogliono metterlo in stazione centrale per cercare di affrontare le violenze, che ormai sono all’ordine del giorno. Ma il riconoscimento facciale non è esente da problemi.

Nei nostri cellulari è già attivo. Il corpo è la nostra password. Nel tempo quelle tradizionali sono destinate a scomparire.

“Attualmente il riconoscimento facciale più diffuso è riconducibile a due grandi strategie corrispondenti a due distinte generazioni tecnologiche. La prima, a sua volta può essere divisa in due strategie: esso può avvenire tramite il confronto delle distanze tra le pupille, la grandezza del naso, delle labbra e altre misure della faccia; oppure attraverso lo studio di come i pixel si raggruppano per formare i vari elementi del viso e paragonarli con altre immagini presenti in un database. Entrambe le tecniche hanno somiglianze con il sensore di rilevamento di impronte digitali”, spiegano su Agenda Digitale.

“La seconda generazione di software per il riconoscimento facciale invece utilizza tecnologie molto più avanzate. Utilizzato dalle piattaforme Facebook, Google e Windows si basa sul machine learning e insegna ai computer a riconoscere i volti mettendo loro a disposizione decine di migliaia di immagini differenti. In questo modo, i sistemi informatici riconoscono quali sono gli elementi univoci di un viso.

Dal punto di vista pratico, il riconoscimento delle persone tramite i tratti dei loro volti si realizza attraverso un processo composto da una pluralità di fasi specifiche e delicate. La prima è costituita dal rilevamento: tramite sensori il sistema informatico attiva le fotocamere ed effettua una foto o un video del soggetto che si trova di fronte a loro; si passa poi all’allineamento: una volta rilevato che una persona si trova di fronte l’obiettivo, il computer o lo smartphone determinano la posizione e inclinazione della testa e le sue dimensioni. Segue la fase della misurazione: il sistema elabora l’immagine raccolta con algoritmi che aiutano a determinare su una scala millimetrica le varie curve e insenature che formano la faccia, creando così un modello del viso. Vi è poi la fase della rappresentazione: altri algoritmi si occupano di tradurre le curve e le insenature in un codice utilizzato per rappresentare il volto e di conseguenza la persona. Ed ancora, la fase del confronto, nella quale il codice ottenuto viene utilizzato dal sistema per confrontare il volto con quelli già presenti nel database. Scorrendo l’elenco si verifica che il codice corrisponda o meno a uno già conosciuto. Arriviamo infine all’identificazione, ossia, l’ultima fase, nella quale si controlla che i volti corrispondenti ai due codici siano effettivamente il medesimo.

Quali errori possono esserci nel riconoscimento facciale

“L’utilizzo dei dati biometrici ha già rilevato molte carenze in grado di causare errori sistematici cosiddetti bias induttivi dell’algoritmo, soprattutto nelle minoranze etniche e, di conseguenza, tali da determinare probabili rischi per le persone. I bias nei sistemi di machine learning, ossia in sistemi di intelligenza artificiale, sono dovuti, ad esempio, alla presenza di dati erronei nel processo di apprendimento automatico.

Esistono due modi principali in cui tale errore può configurarsi: in un caso i dati in precedenza raccolti non rappresentano la realtà; nell’altro, essi riflettono i pregiudizi già esistenti. Ebbene. Se l’intelligenza artificiale è addestrata con dati che sono il risultato di pratiche o tendenze discriminatorie, come ad esempio le percentuali di assunzione in base al sesso o i tassi di recidiva criminale associati alla nazione di provenienza (il caso delle assunzioni di Amazonper dire), i risultati che si otterranno rischiano di perpetuare questi stessi pregiudizi, confermandoli. Sotto tale profilo, le aziende devono essere consapevoli della responsabilità circa gli effetti di valutazioni condotte con sistemi automatici.

L’utilizzo della biometria inoltre presenta risvolti problematici per la riservatezza delle persone. La legittima protezione della privacy difatti viene limitata da fenomeni di sospetto sociale quale quelli connessi a fatti terroristici, alla prevenzione di reati ed al controllo nei luoghi di lavoro per massimizzare i profitti ovvero per ridurre le perdite dovute allo scarso rendimento del lavoratore”.

Leggi le ultime news su: https://w3b.today

Può interessarti anche: Macron vuole mettere in campo l’intelligenza artificiale per la “sicurezza” dei giochi olimpici

Seguici su Telegram https://t.me/presskit

Seguici su Facebook https://www.facebook.com/presskit.it