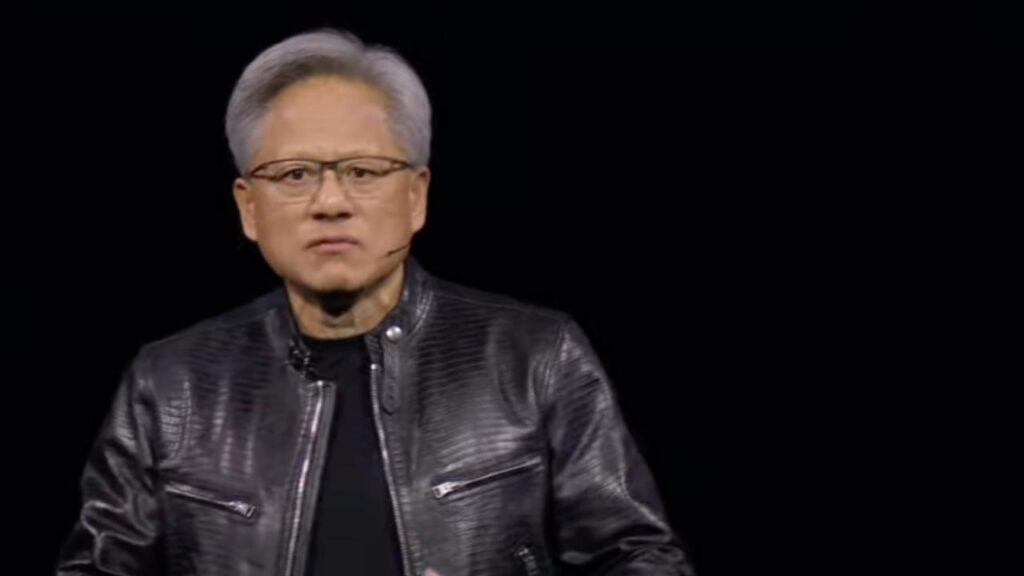

Uno dei settori che ha tratto enormi benefici dalla scala è quello dei modelli linguistici di grandi dimensioni, come sottolineato da Jensen Huang, CEO di Nvidia. Dopo l’invenzione del trasformatore, abbiamo potuto adattare questi modelli a velocità incredibili, raddoppiando le loro capacità ogni sei mesi. Ma come è possibile che raddoppiando ogni sei mesi abbiamo fatto crescere il settore e aumentato i requisiti computazionali?

La risposta risiede nella necessità di raddoppiare non solo le dimensioni del modello, ma anche le informazioni necessarie per alimentarlo. Ogni volta che si raddoppiano i parametri di un modello, si deve anche aumentare adeguatamente il conteggio dei token di allenamento. Questa combinazione definisce la scala di calcolo richiesta. L’ultimo modello di intelligenza artificiale all’avanguardia conta circa 1,8 trilioni di parametri, richiedendo diversi trilioni di token per l’addestramento.

La moltiplicazione di questi parametri e token porta a circa 30, 40, 50 miliardi di quadrilioni di operazioni in virgola mobile al secondo. Facendo un rapido calcolo sul CO2, emerge che, con una GPU da un petaFLOP, ci vorrebbero 30 miliardi di secondi, equivalenti a circa 1.000 anni, per addestrare un modello di tale portata. Nonostante i tempi lunghi, Huang sostiene che ne vale la pena, ma ovviamente si cercano soluzioni per accelerare il processo. La risposta risiede nella creazione di GPU molto più potenti.

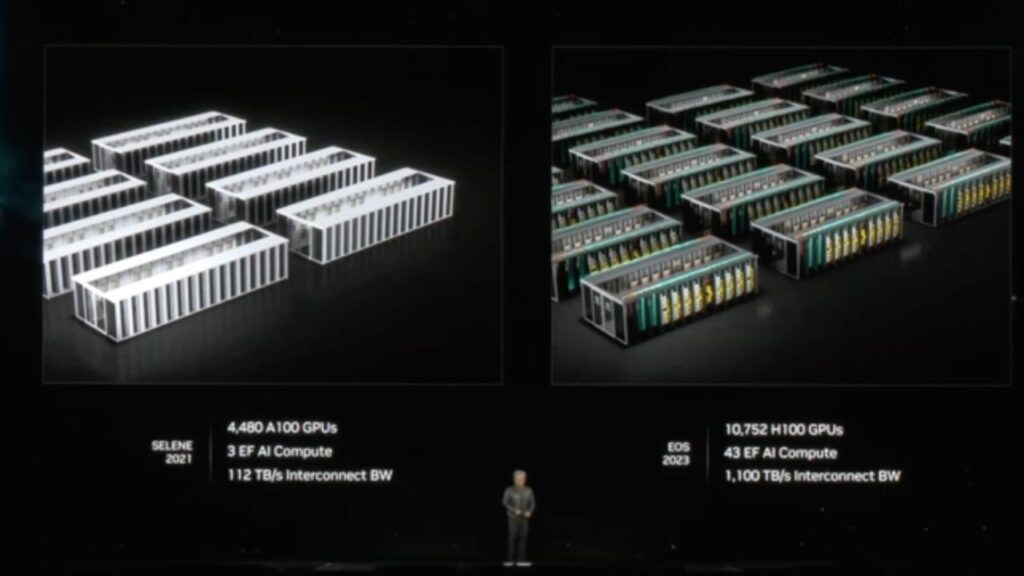

Nvidia ha riconosciuto presto la necessità di GPU più grandi e ha risposto con innovazioni come i nuclei tensoriali e l’avanzamento di NVLink, permettendo la creazione di GPU praticamente giganti collegate tramite reti straordinarie come quelle di Mellanox e Infiniband. Questo ha portato alla costruzione di supercomputer lungo tutto il percorso evolutivo dell’azienda, come Selene nel 2021 con circa 4.500 GPU, fino ad arrivare a Eos nel 2023, uno dei più grandi supercomputer IA del mondo.

Per aiutare il mondo a costruire questi sistemi, Nvidia ha dovuto costruirli prima internamente, sviluppando chip, sistemi, networking e tutto il software necessario. Huang descrive questi sistemi come incredibili, con software in grado di distribuire il calcolo su migliaia di GPU, massimizzando l’efficienza energetica e il tempo di calcolo, oltre a contenere i costi. Queste innovazioni sono state fondamentali per i progressi raggiunti finora.

Mentre ammiriamo il miracolo di ChatGPT, Huang riconosce che c’è ancora molta strada da fare. Abbiamo bisogno di modelli ancora più grandi, addestrati con dati multimodali, non solo testo su Internet, ma anche immagini, grafici, diagrammi e video. Questi modelli, per sviluppare un buon senso pratico, dovranno osservare molti video del mondo e combinare molte lingue. Utilizzeranno anche la generazione di dati sintetici, simulando scenari come facciamo noi con la nostra immaginazione.

L’apprendimento per rinforzo sarà praticato nella nostra mente e l’intelligenza artificiale si allenerà a vicenda come studenti, insegnanti e dibattitori, aumentando le dimensioni e le capacità dei nostri modelli. Questa visione di Huang mostra un futuro di crescita esponenziale per l’intelligenza artificiale, guidato dall’innovazione continua e dall’espansione delle capacità computazionali.

Le opinioni espresse in questo articolo sono dell’autore.

Leggi le ultime news su: https://w3b.today

Può interessarti anche: I modelli linguistici di grandi dimensioni (o IA generativa) nel settore sanitario aprono nuovi rischi

Seguici su Telegram https://t.me/presskit

Seguici su Facebook https://www.facebook.com/presskit.it

Copiate l’articolo, se volete, vi chiediamo solo di mettere un link al pezzo originale.